L’interopérabilité, c’est-à-dire la capacité pour différents systèmes de communiquer entre eux, est omniprésente dans notre quotidien. Partout où sont établis des standards – dans la langue et l’écriture, dans la circulation routière, dans les pièces mécaniques de nos machines, dans la connectique de nos appareils électroniques, dans les formats de nos fichiers numériques –, un certain nombre de règles permettent à deux systèmes distincts de fonctionner comme un seul, formant un écosystème.

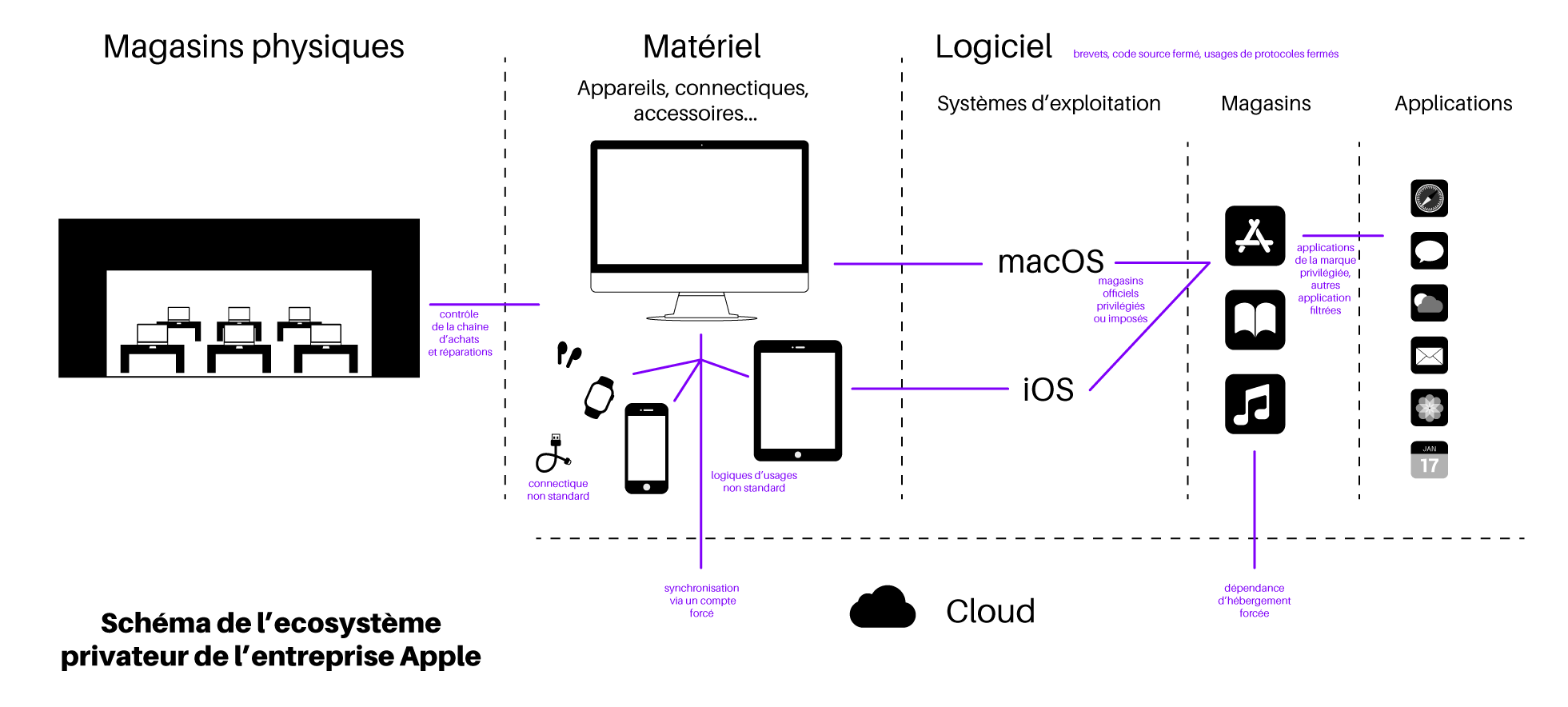

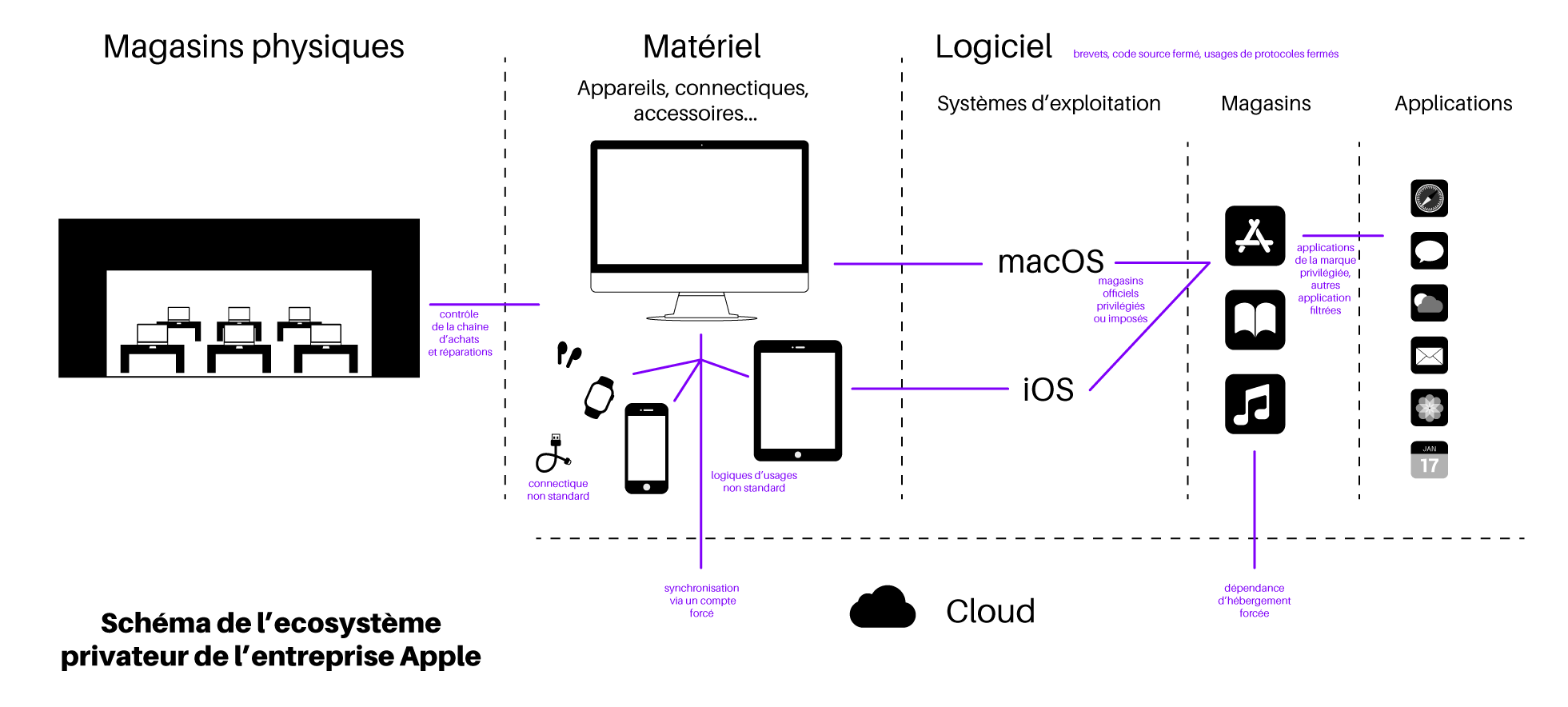

Le monde informatique est fait de ces règles que l’on appelle « protocoles ». Certaines entreprises font le choix de concevoir plutôt des protocoles propriétaires, c’est-à-dire de poser des barrière pour bloquer la communication avec d’autres systèmes qui ne seraient pas sous leur contrôle. Cela leur permet de s’assurer que les personnes qui utilisent leurs logiciels ou leurs matériels soient dépendantes de l’entreprise. L’entreprise Apple, par exemple, est connue pour fonder l’ensemble de son modèle économique sur ces stratégies de fermeture : si la communication entre les différents appareils et logiciels Apple est possible, elle est rendue difficile voire impossible avec d’autres appareils et logiciels n’appartenant pas à la marque. Posséder un ordinateur Apple implique d’utiliser le système d’exploitation d’Apple, d’utiliser la connectique Apple et d’intégrer des logiques d’utilisation souvent très différentes, rendant les utilisateur·rices captif·ves de leur écosystème.

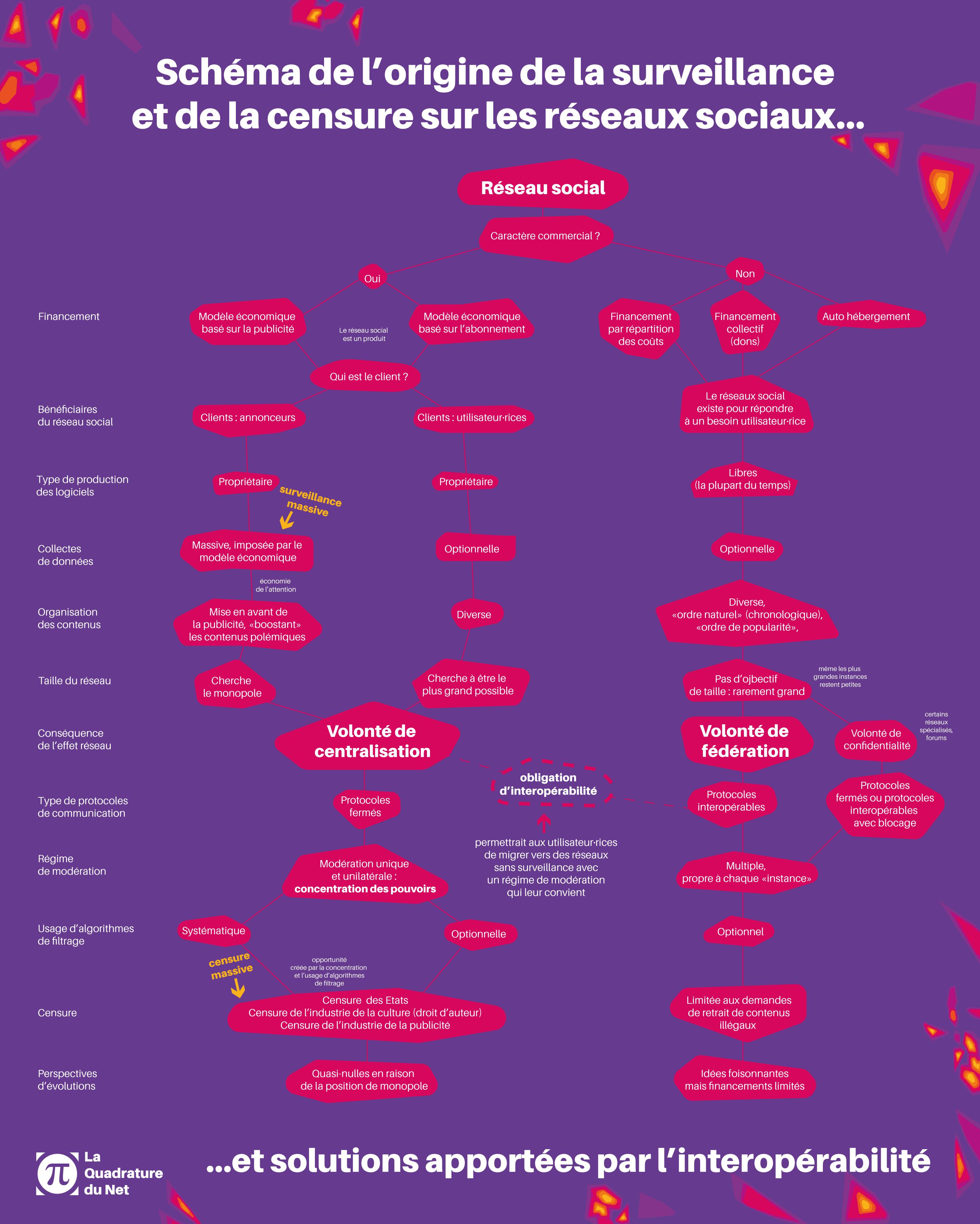

Les réseaux sociaux commerciaux comme Facebook, Twitter, Instagram, Youtube, TikTok et bien d’autres reposent sur l’absence de protocole pour communiquer vers l’extérieur : ils empêchent leurs utilisateur·rices d’opter pour d’autres moyens de communiquer et d’échanger des informations. Les contenus publiés sur l’un de ces réseaux sociaux ne sont accessibles qu’en passant par celui-ci. Toute communication vers l’extérieur est volontairement bloquée et il est parfois même nécessaire de se créer un compte pour consulter un contenu via une interface imposée (interface web ou application).

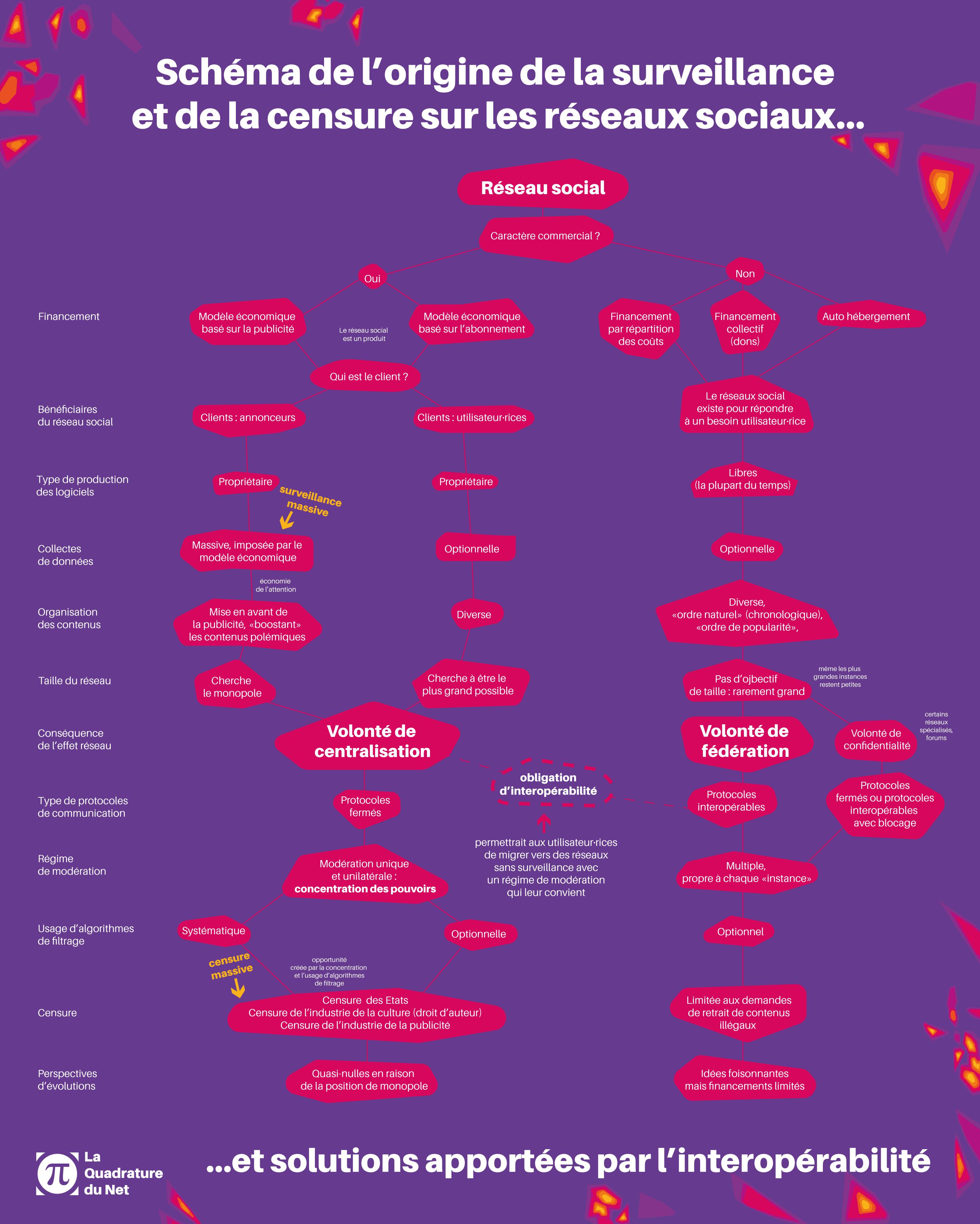

La stratégie des réseaux sociaux commerciaux fonctionne sur une logique de régie publicitaire. Pour être rentables, il leur faut rassembler un public auquel exposer la publicité de leurs annonceurs. Dans un premier temps, ces entreprises s’emploient à créer un logiciel de réseau social désirable, en mettant l’accent sur des fonctionnalités innovantes pour attirer des utilisateur·rices. L’usage de protocoles fermés n’est alors pas encore une nécessité. On se rappelle par exemple de Facebook, qui, entre 2008 et 2015, supportait le protocole XMPP dans sa messagerie privée, ce qui permettait à ses utilisateur·rices d’échanger avec les personnes ayant un compte AIM, ou utilisant d’autres messageries basées sur ce protocole. Ils constituent de cette manière une grosse base d’utilisateur·rices afin de renforcer ce qu’on appelle l’« effet réseau » de leur logiciel : plus il y a des personnes présentes sur le réseau social, plus cela en attire de nouvelles.

Une fois un certain seuil d’utilisateur·rices atteint, pour avoir une stratégie publicitaire plus offensive, les réseaux sociaux commerciaux investissent l’ensemble de leurs ressources pour servir la publicité. Cela a pour effet de dégrader le service, notamment en réorganisant les contenus créés sans but commercial en les diluant dans ceux « sponsorisés ». Le réseau social commercial n’est alors plus aussi attrayant pour le service qu’il offre, mais seulement en ce qu’il permet de communiquer avec les gens qui y ont un compte. La stratégie de mise en captivité devient alors une nécessité. Les techniques utilisées pour empêcher les utilisateur·rices de partir et en attirer d’autres malgré la dégradation du service passent alors par la fermeture des protocoles – voire l’impossibilité stricte de communiquer vers l’extérieur –, la complexification de l’accès au contenu pour les personnes non connectées, et bien d’autres obstacles.

Ce fonctionnement en silos semble être la norme aujourd’hui car cette méthode de captivité est efficace : alors qu’une grande partie des utilisateur·rices d’un réseau social commercial comme Facebook sont très critiques de ses méthodes de surveillance commerciale, de ses méthodes de modération, de son volontarisme à appliquer la censure réclamée par les États, de sa manière d’afficher en priorité des contenus publicitaires, iels continuent de l’utiliser car tous·tes leurs ami·es y sont.

Le caractère commercial à l’origine de la nécessité de centralisation

Dissection d’un GAFAM, analyse technique de la logique de centralisation

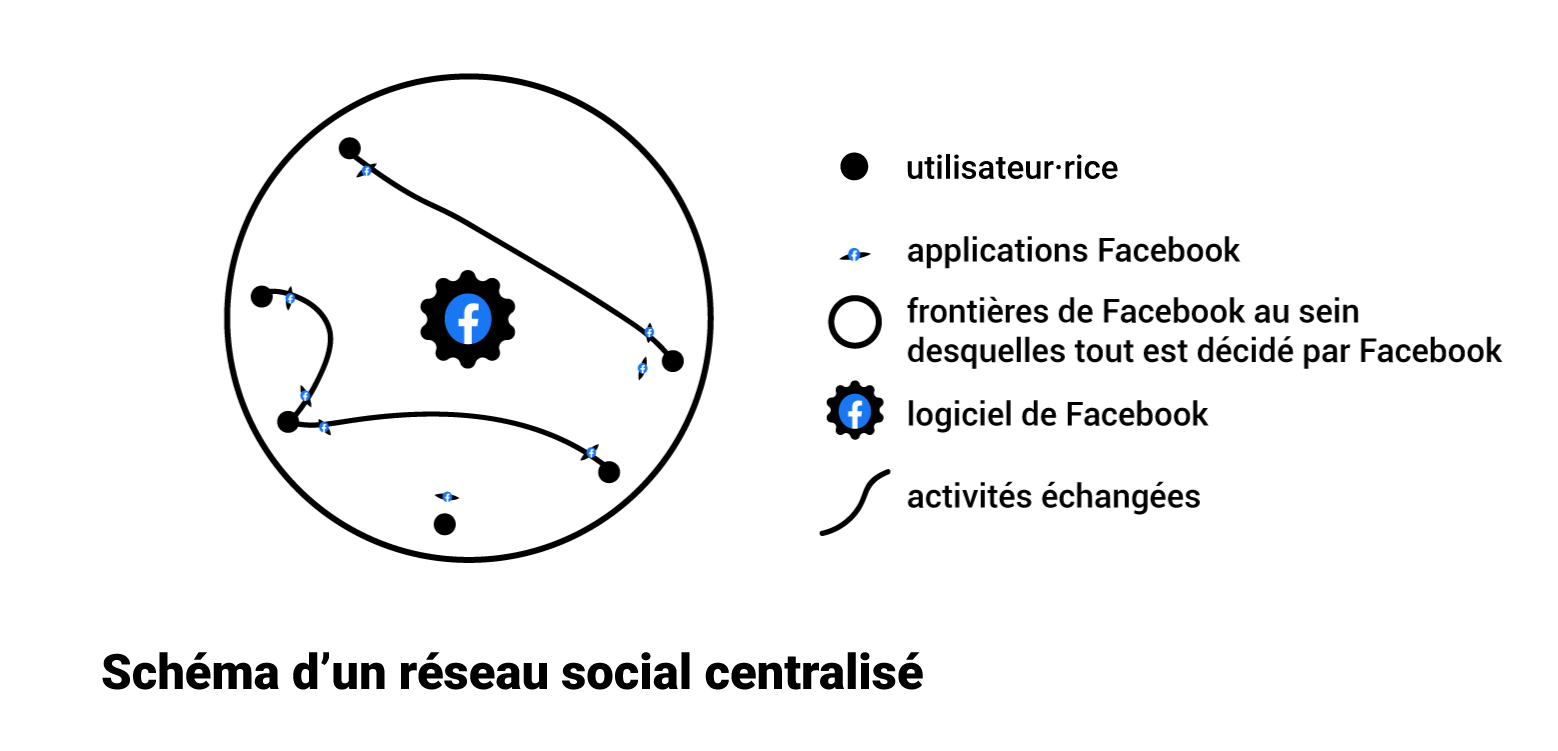

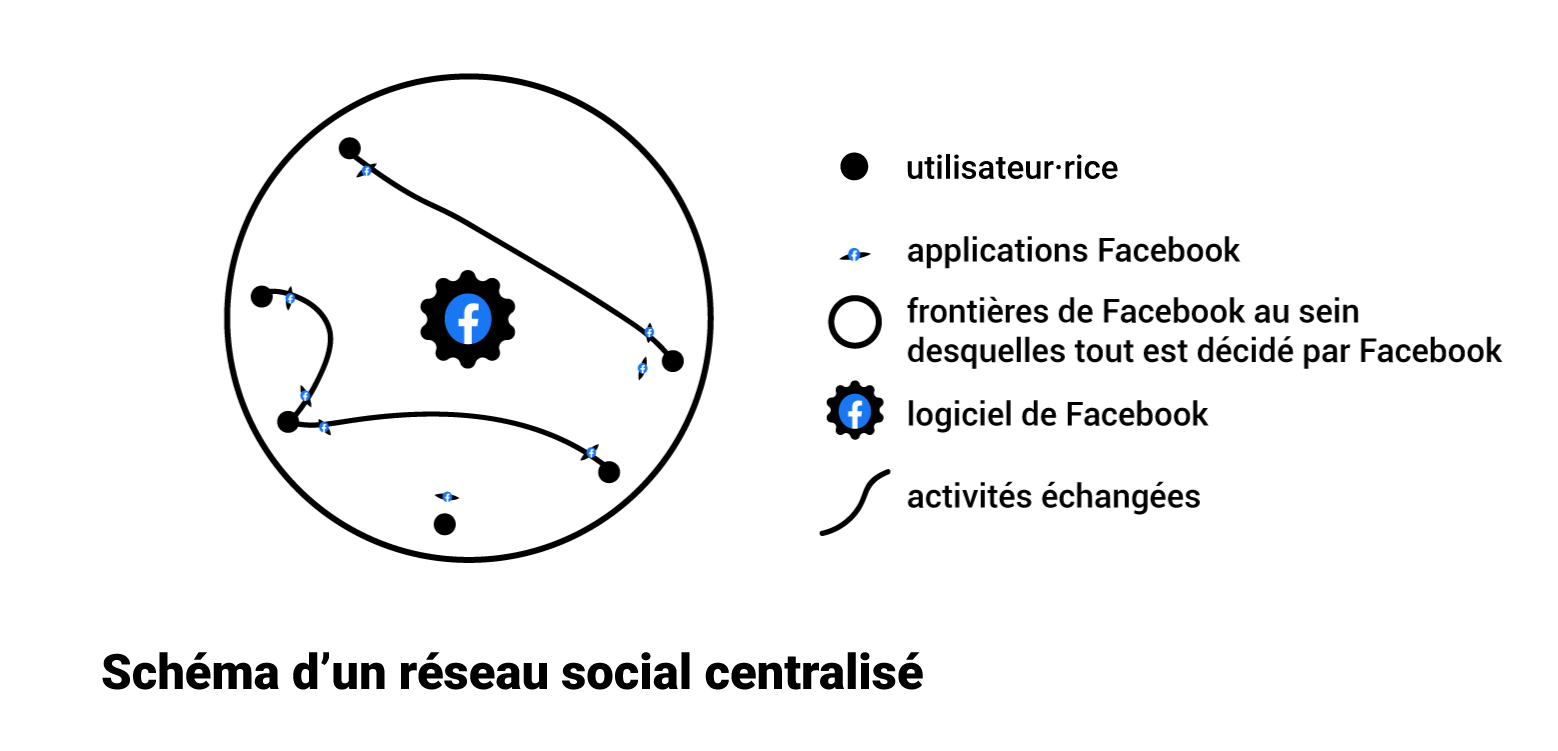

Pour mieux comprendre comment les réseaux sociaux commerciaux concentrent autant de pouvoir, commençons par analyser ce qui les compose. Nous prendrons ici l’exemple de Facebook, mais il en est de même pour Youtube, Tiktok et les autres :

Lorsque l’on parle de Facebook, on parle en réalité de plusieurs choses différentes. Premièrement, pendant longtemps, Facebook était le nom de l’entreprise qui commercialise le réseau social (depuis 2021, cette entreprise s’appelle Meta). Deuxièmement, c’est le nom du logiciel de réseau social. Ce logiciel détermine les règles applicables au service : il prévoit non seulement les fonctionnalités (l’échange de contenus privés, publics, d’images, etc.), mais aussi les conditions à respecter pour en bénéficier. Ce logiciel de réseau social détermine ainsi les restrictions, comme le fait d’empêcher de pouvoir communiquer avec d’autres logiciels que ceux de l’entreprise, via l’obligation d’utiliser des protocoles propriétaires. Ce logiciel est hébergé uniquement sur les serveurs de l’entreprise, ce qui garantit à cette dernière d’être la seule à pouvoir administrer le réseau social (c’est aussi ce qui lui confère une responsabilité juridique particulière). Troisièmement, Facebook est aussi le nom des interfaces qui permettent d’accéder au réseau social, que l’on appelle « clients ». Il s’agit à la fois de l’interface web accessible depuis un navigateur que des applications mobiles que l’internaute installe sur son smartphone.

Les stratégies de protocoles fermés sont appliquées à tous les étages techniques, ce qui confère au réseau social cette nature centralisée :

- il n’est pas possible d’héberger les contenus que l’on poste sur le réseau social ailleurs que sur les serveurs de l’entreprise ;

- le logiciel est construit de manière à ce qu’il ne soit pas possible d’accéder directement à des contenus publiés sur un autre réseau social ;

- la connexion au logiciel de réseau social ne peut se faire que via des clients développés et proposés par le réseau social, il est impossible d’utiliser des clients alternatifs (ou alors de manière très difficile en raison du manque de documentation des API pour les développeurs·euses tiers·ces ou de leurs restrictions d’usages).

Le principe d’interopérabilité veut précisément briser ces stratégies de centralisation technique qui sont à l’origine de la concentration du pouvoir des réseaux sociaux sur leurs utilisateur·rices. L’interopérabilité rendrait au contraire toutes ces choses possibles : héberger ses contenus où l’on veut, employer le logiciel de réseau social que l’on veut pour communiquer avec qui on veut, ou encore utiliser un client de son choix.

Centraliser et enfermer pour mieux surveiller

Le fonctionnement en silo des réseaux sociaux commerciaux maintient leurs utilisateur·rices captif·ves et leur permet d’imposer leurs conditions. Leur modèle économique étant basé sur la publicité ciblée, ils traitent un très grand nombre d’informations. Premièrement, les réseaux sociaux collectent les données fournies directement par l’utilisateur·rice. Cela varie d’un réseau social à un autre (en fonction de la politique propre à chaque service), mais on retrouve souvent l’âge, le nom, la nationalité, les centres d’intérêts, etc. Deuxièmement, les réseaux sociaux déduisent des informations à partir de l’usage fait par l’internaute. Ils peuvent recréer le graphe social (c’est-à-dire avec qui l’internaute interagit et à quelle fréquence), mais ils peuvent également traiter les métadonnées, c’est-à-dire ce qui entoure une communication : heure, fréquence et lieu de connexion, type de matériels et de logiciels utilisés, temps passé sur un contenu, etc.

Le but de cette collecte d’information est de dresser des profils types d’utilisateur·rices afin de leur adresser la publicité la plus ciblée possible – donc la plus « efficace » possible commercialement parlant. Par exemple, si vous êtes abonné·e à une page ou un compte d’un bar LGBT et que vous « likez » des posts de la Marche des Fiertés, le réseau social pourra commencer à déduire votre orientation sexuelle. Les réseaux sociaux commerciaux investissent beaucoup d’énergie, de recherche et développement dans ce domaine car c’est ce qui leur permet de satisfaire leurs vrais clients et sources de revenus : les annonceurs.

En théorie, en Europe, le règlement général sur la protection des données (RGPD) interdit de récupérer ces données sans le consentement libre de l’utilisateur·rice. En vertu ce de texte, un consentement est « libre » s’il est donné sans la menace d’être exposé·e à des « conséquences » négatives, comme de ne pas pouvoir accéder au service ou devoir payer pour y accéder. Ce règlement n’est pas respecté par la plupart des réseaux sociaux commerciaux. La grande majorité des utilisateur·rices, s’iels avaient le choix, refuseraient de donner les informations sur lesquelles reposent l’économie entière des entreprises concernées. C’est sur cette base qu’en 2018 La Quadrature du Net a déposé, avec 12 000 utilisateur·rices, des plaintes collectives contre les réseaux sociaux commerciaux Facebook et Linkedin. La procédure est encore en cours devant la CNIL irlandaise.

Le RGPD et la nécessité du consentement individuel ne sont donc pas suffisant·es en pratique pour lutter contre la surveillance commerciale. Ce règlement est très peu appliqué et ne propose qu’une solution individuelle, qui place l’utlisateur·rice devant un choix sans liberté : consentir à la publicité ou renoncer à utiliser le réseau social (donc se couper de ses contacts). Nous pensons, à l’inverse, que les réseaux sociaux et leur politique de modération et de fonctionnement doivent être gérés collectivement par les utilisateur·rices iels-mêmes. Autrement dit, il ne sert à rien d’essayer de réparer les réseaux sociaux commerciaux, il est préférable de s’organiser directement pour reprendre le pouvoir des communautés.

Si les réseaux sociaux étaient interopérables, les internautes pourraient déménager vers des réseaux sociaux non commerciaux, qui n’imposent pas de surveillance à leurs utilisateur·rices, sans pour autant perdre le contact avec leurs proches qui ont toujours un compte sur un réseau social commercial.

Modération, censure, espaces d’expression

Centralisation : régime de modération unique

Il existe de nombreux régimes de modération qui répondent à des besoins différents. Tout le monde est confronté au quotidien, en dehors des réseaux sociaux, à une multitude de régimes. Par exemple, en présence d’enfants, il est souvent d’usage de surveiller son langage et de ne pas employer de vocabulaire grossier. En fonction du contexte professionnel ou amical dans lequel on se trouve, on adaptera son registre de mots. Cela ne représenterait donc aucun intérêt de vouloir unifier ces régimes d’expression et impliquerait même, au contraire, une perte de diversité culturelle et un blocage des perspectives d’évolution de la langue. La langue est interopérable dans le sens où elle fournit à la fois un certain nombre de standards permettant aux gens d’être compris entre eux sans empêcher pour autant que puissent exister des règles plus spécifiques dans certains groupes. Il peut s’agir de règles tacites ou de règles verbalisées par le groupe. Cette diversité de régimes d’expression coexiste sans que l’un d’entre eux soit intrinsèquement meilleur.

Nous avons expliqué plus haut comment le fonctionnement en silo des réseaux sociaux commerciaux leur permet de concentrer tous les pouvoirs et d’imposer unilatéralement un certain nombre de règles à l’ensemble de leurs utilisateur·rices. En pratique, cela revient à déposséder en partie les espaces de discussion de leur pouvoir de choisir un régime d’expression donné. Cette dépossession n’est, certes, pas entière, car un certain nombre de régimes d’expressions sont compatibles avec les règles fixées par le réseau social. En revanche, dès qu’il s’agit de vouloir publier un contenu interdit par le réseau social, même lorsque ce contenu n’est pas illégal, les utilisateur·rices se retrouvent bloqué·es dans leur expression, ou censuré·es.

Les questions de pouvoir d’expression ne sont pas spécifiques à l’usage des outils numériques mais générales à l’ensemble de la société. La liberté d’expression, la liberté d’opinion, la liberté de recevoir ou de communiquer des informations, la liberté de la presse ainsi que les limites de ces droits que sont la diffamation, l’injure ou le dénigrement entendent encadrer nos échanges. Ces droits et leurs limites sont souvent invoqués pour formuler deux critiques à l’égard de ces réseaux. La première provient d’utilisateur·rices frustré·es d’avoir vu des contenus légaux modérés, iels sont attaché·es à voir leur liberté d’expression assurée et voudraient que les réseaux sociaux commerciaux n’aient pas le droit de supprimer des contenus qui ne soient pas illégaux. La seconde provient d’utilisateur·rices sont confronté·es à des contenus qui les offensent et aimeraient ne plus l’être, même si ces contenus ne sont pas manifestement illégaux.

Ces deux critiques quant à l’excès ou au manque de censure de la part des réseaux sociaux sont caractéristiques du problème central : celui d’un régime de modération unique imposé par les plateformes.

Le choix d’une organisation centralisée, qui impose les même règles à une grande quantité de groupes et de personnes différentes, est assez absurde et insatisfaisant pour les utilisateur·rices des réseaux sociaux. Mais la centralisation engendre d’autres problèmes, que nous évoquons par la suite, davantage dus à la concentration des pouvoirs.

Censure passive due au modèle économique

La place privilégiée des contenus publicitaires

Les réseaux sociaux commerciaux ont cette particularité de ne pas seulement héberger le contenu de leurs utilisateur·rices, mais également celui de leurs clients : les annonceurs. Honneur aux payeurs, l’ensemble du réseau social est façonné dans un seul but : maximiser l’exposition au contenu publicitaire et renforcer son efficacité, c’est-à-dire conduire les utilisateur·rices à cliquer sur la publicité. Les données personnelles recueillies servent donc à dresser des profils d’utilisateur·rices pour leur adresser la publicité à laquelle iels seraient le plus sensibles, mais tout le reste du réseau social sert également cet objectif. Les algorithmes ont donc pour but de donner plus ou moins d’importance à tel ou tel contenu afin de le sur-visibiliser ou le sous-visibiliser, dans l’optique de pousser l’utilisateur·rice à rester le plus longtemps sur le réseau, et à être la ou le plus receptif·ve possible à la publicité.

Économie de l’attention, viralité boostée et censure par enterrement

L’ensemble de ces stratégies visant à pousser l’utilisateur·rice à rester longtemps sur la plateforme est couramment appelé « économie de l’attention ». En pratique, les algorithmes d’organisation des contenus repèrent ceux qui font polémique et qui provoquent un engagement spontané de la part des utilisateur·rices, afin de leur donner une place privilégiée en les faisant apparaître plus haut dans le flux de l’internaute ou dans les résultats de recherche, voire en envoyant une notification à l’utilisateur·rice. L’espace d’expression étant limité, cette mise en avant de certains contenus conduit également à sous-visibiliser les autres : les contenus plus complexes, plus étayés, nécessitant plus d’investissement de la part du public et n’obéissant pas aux critères de création de contenus valorisés par les réseaux sociaux commerciaux sont moins souvent mis en avant et proposés à la lecture. Ils subissent alors une censure invisible, dite « censure par enterrement ».

Ces mécanismes renforcent l’addiction au réseau social et sont à l’origine de la viralité mondiale de certains contenus. Ils sont également à l’origine de la grande propagation de contenus problématiques. Les contenus qui entraînent beaucoup d’engagement de la part des internautes sont souvent des contenus clivants et choquants. C’est le cas des contenus racistes, du harcèlement, des fausses informations, des images d’actes de violence.

Ces contenus suscitent de l’engagement de toute part : celleux qui les soutiennent les partagent en masse, et celleux qui s’y opposent sont offusqué·es et les partagent en masse pour les dénoncer. En 2019, la tuerie de l’église de Christchurch en Nouvelle-Zélande a été filmée et diffusée en direct par son auteur sur Facebook. Elle a été massivement partagée par des personnes d’extrême droite. Facebook n’a pas bloqué ces images et, pire, leur a donné une viralité supplémentaire car, étant choquantes, elles ont suscité beaucoup d’engagement.

Malheureusement, quand il s’agit de lutter contre les effets délétères des stratégies commerciales des réseaux sociaux, le réflexe des États n’est jamais de remonter aux causes du problème. La solution proposée est toujours d’en passer par une loi de censure, imposant aux réseaux sociaux de supprimer tel ou tel type de contenus, validant ainsi la giga-structure centralisée des réseaux sociaux commerciaux, pourtant à la base du problème.

Censure active

Les réseaux sociaux commerciaux ayant un grand pouvoir sur leurs utilisateur·rices, il est intéressant de voir et de critiquer les décisions prises par les entreprises qui les possèdent. On peut penser par exemple à la volonté de Mark Zuckerberg de mener une politique « antisuicide » sur son réseau social (Facebook) reposant sur l’analyse automatisée des contenus et non un accompagnement humain, ou encore aux transformations qu’a subies Twitter après son rachat par Elon Musk en novembre 2022. On voit alors comment la volonté d’un seul homme ou d’une seule entreprise peut avoir des conséquences sur des millions de personnes. Mais il est plus intéressant encore de voir que la majorité des décisions qui sont prises viennent surtout d’autres forces extérieures à l’entreprise, et auxquelles les réseaux sociaux commerciaux doivent se plier pour conserver leur place hégémonique.

Le pouvoir des annonceurs

Le modèle économique basé sur la publicité motive les réseaux sociaux commerciaux à se modeler en fonction de celle-ci. Nous avons qualifié cette dynamique de « censure passive » car la censure n’en est qu’un effet secondaire. Mais il existe aussi une demande active de censure de la part des annonceurs, en particulier pour que leur publicité ne soit pas affichée à côté de certaines catégories de contenus. Récemment avec Twitter, des annonceurs se sont retirés en raison de la recrudescence de contenus d’extrême-droite. Cette pression possible des annonceurs sur les plateformes explique aussi pourquoi on retrouve souvent des règles de censure proscrivant la nudité. Cette influence n’est pas spécifique aux réseaux sociaux : partout où il y a un financement publicitaire, les annonceurs ont le pouvoir de retirer leur publicité (et donc leur financement) si leurs exigences en matière de censure ne sont pas respectées (la presse papier, également, est souvent tributaire du pouvoir de ses annonceurs).

Le pouvoir des États

Le pouvoir centralisé des réseaux sociaux commerciaux représente aussi une opportunité de pouvoir pour les États. Nous l’avons particulièrement vu durant ces cinq dernières années. Les volontés de censure des États viennent du constat d’un changement dans les dynamiques d’expression en ligne dont nous avons expliqué les causes (le caractère commercial des réseaux sociaux et leur caractère centralisé). Pour autant, le biais d’administration centralisée de l’État ou le manque de temps nécessaire à cette compréhension n’ont pas conduit les représentant·es politiques à vouloir remonter à la racine des problèmes. À chaque « problème » identifié — haine et harcèlement, contenus violents, fausses informations, etc — l’urgence les a toujours conduit à valider le pouvoir de l’instance centralisée des réseaux sociaux commerciaux en leur imposant de durcir leur modération, souvent dans des délais courts qui ne peuvent être respectés que par l’usage d’algorithmes de filtrage des contenus.

Le pouvoir de l’industrie culturelle

La création de contenus sur les réseaux sociaux est très prolifique et a apporté un renouveau dans les moyens d’expression et la production de contenus créatifs. Le vieux modèle de production d’œuvres culturelles, façonné lui aussi pour obéir à des impératifs économiques au détriment de l’écosystème créatif et des populations nécessitant un accès à la culture, n’a pas disparu pour autant. Sous la pression de l’industrie culturelle, les réseaux sociaux commerciaux — c’est particulièrement le cas de Youtube — ont mis en place des algorithmes pour censurer certains contenus qui ne respecteraient pas le droit d’auteur. L’industrie culturelle a par la suite, avec l’aide du législateur, réussi à imposer cette idée qu’il faudrait surveiller l’ensemble des contenus en ligne afin de repérer les œuvres « illégalement » partagées. Le fonctionnement de l’outil Content ID de Youtube, qui consiste à comparer les condensas (hash) de musiques et vidéos à une base de données de contenus protégés et, en cas de similitude, à bloquer le contenu a donc depuis été mis en place sur tous les grands réseaux sociaux commerciaux.

Centralisation et censure par algorithme

La très grande quantité de contenus que les réseaux sociaux commerciaux hébergent demande un lourd travail de modération. La motivation économique étant la raison première de leur existence, ils ont rapidement cherché à « rationaliser » la modération, à l’aide de la sous-traitance de ce travail à des « fermes de modérateurs » et à l’usage d’algorithmes de filtrage.

Les « fermes de modérateurs » sont des entreprises, souvent implantées dans des pays où les salaires sont très bas. Les conditions de travail y sont généralement très dures et les salarié·es sont exposé·es à une quantité phénoménale de contenus violents (aux conséquences psychiques lourdes sur les personnes) sortis de leur contexte (le contexte culturel variant d’un pays à l’autre, le contexte d’une publication serait de toute manière très difficile à appréhender). Leur travail sert à modérer les contenus des réseaux sociaux commerciaux et à entraîner des algorithmes dans le but d’automatiser la modération.

Pour ces raisons, la modération par algorithme n’est pas souhaitable. Elle est en plus de cela largement fantasmée. Comme en témoigne l’exemple de la tuerie de Christchurch que nous présentions plus tôt : les algorithmes remplissent mal l’objectif de censure qui leur est donné et laissent passer des contenus qu’ils étaient censés censurer. Ces erreurs fonctionnent aussi dans l’autre sens : certains contenus qui ne devraient pas être censurés par l’algorithme le sont quand même. Diverses représentations d’œuvres d’art se sont ainsi retrouvées censurées, suscitant de vives polémique.

Le législateur, valide, encourage et va parfois jusqu’à imposer l’usage des algorithmes de filtrage en exigeant des délais très court aux retraits de contenus. La directive européenne sur le droit d’auteur et le règlement européen relatif à la prévention de la diffusion de « contenus à caractère terroriste » en ligne qui imposent l’usage de ces algorithmes semblent passer totalement à côté de la réalité de comment sont entraînés ces algorithmes et de leur soi-disant « efficacité ».

L’interopérabilité, et son objectif de décentralisation, permettrait de remettre en avant la modération humaine effectuée par des personnes concernées ayant un regard plus juste et contextualisé sur les contenus à modérer.

L’obligation d’interopérabilité des réseaux sociaux comme outil de leur régulation

L’interopérabilité des réseaux sociaux consiste à permettre à un·e utilisateur·rice inscrit·e sur une plateforme A de pouvoir communiquer avec celleux inscrit·es sur une plateforme B, et inversement, sans pour autant avoir besoin de compte sur cette deuxième plateforme. Un·e utilisateur·rice pourrait écrire à des personnes qui sont sur une autre plateforme et s’abonner à leurs fils d’actualités ou pages sans avoir besoin de compte chez les autres réseaux sociaux, donc sans accepter non plus leurs conditions générales d’utilisation et leur surveillance.

L’objectif principal de La Quadrature du Net lorsqu’elle demande au législateur de contraindre les plus gros réseaux commerciaux de devenir interopérables est de briser leurs silos afin que leurs utilisateur·rices puisse échapper à leur captivité et rejoindre d’autres réseaux. Le fait de briser ces silos a de nombreuses conséquences possibles, dont certaines nous semblent particulièrement désirables.

Casser les silos : ouvrir de nouveaux possibles

Comment cela fonctionne ? L’exemple du fédivers

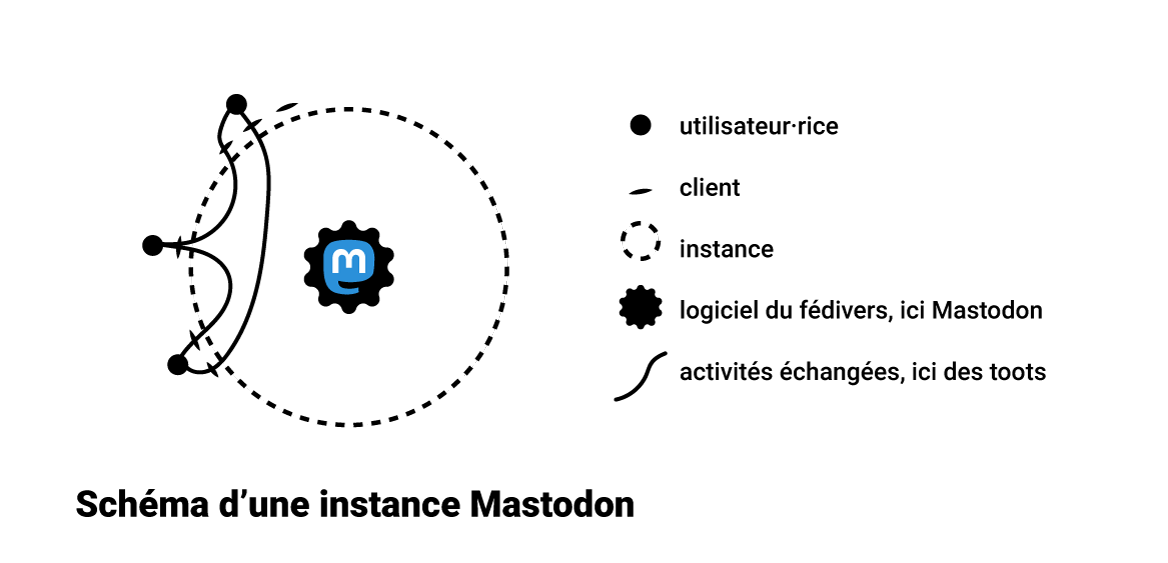

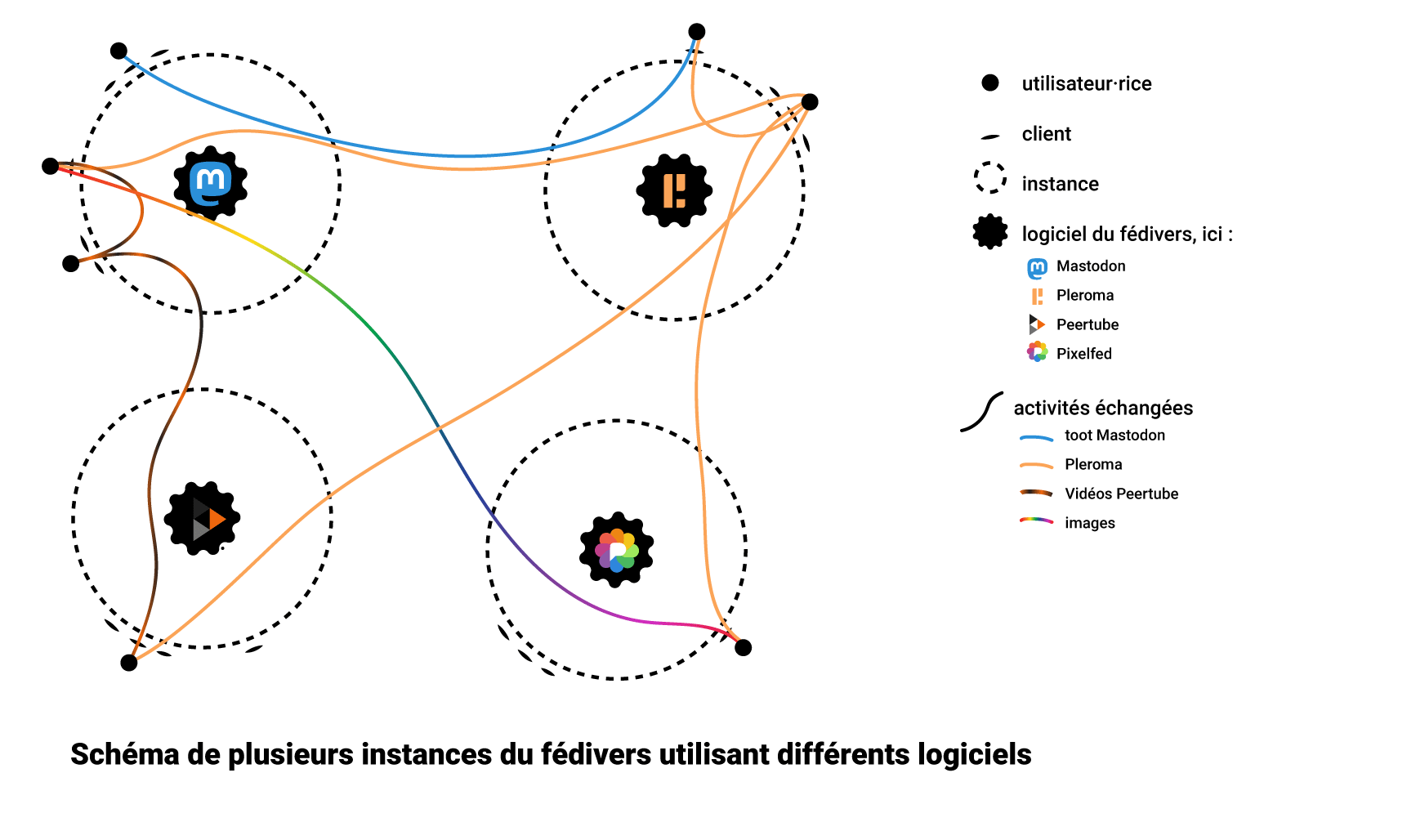

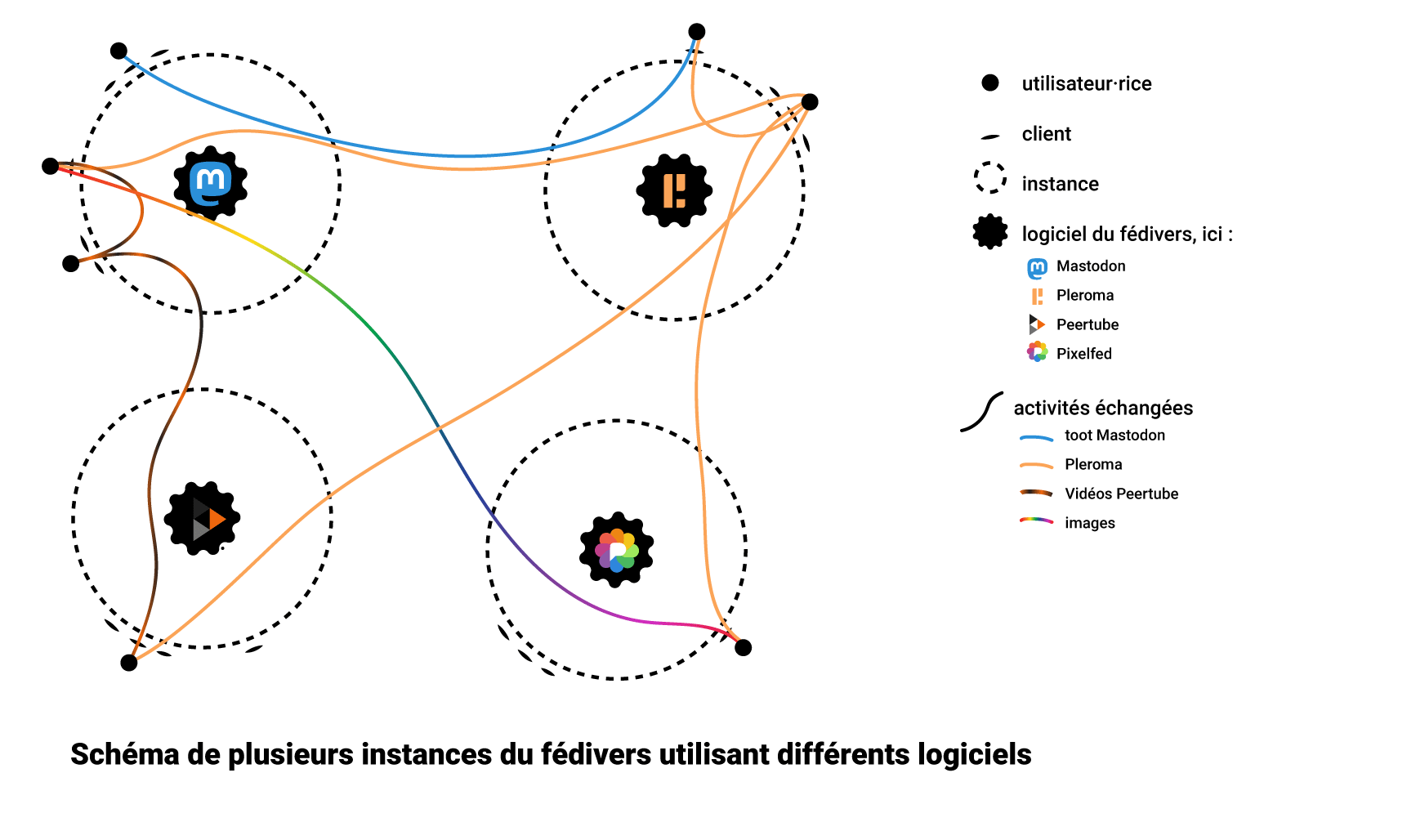

Le fédivers (de l’anglais fediverse, mot-valise entre « fédération » et « univers ») est un grand réseau social permettant d’échanger des informations, des photos, des vidéos, de la musique, … Il est très différent des réseaux sociaux commerciaux dans sa conception, mais s’utilise de manière similaire au quotidien. Nous prenons cet exemple car il a connu un essor ces dernières années (notamment avec le logiciel Mastodon), mais il ne s’agit pas forcément pour autant de la meilleure solution technique : plusieurs voies sont en cours de développement et les choix techniques et standards choisis ont toujours des conséquences sur l’organisation des réseaux et sur les utilisateur·rices. L’avantage des protocoles ouverts comme ActivityPub (sur lequel se fonde le fédivers), ou encore Matrix, Solid, XMPP, Diaspora, etc., est qu’ils rendent possibles de créer des ponts entre eux, de « traduire » un protocole vers un autre. Ces protocoles ont donc l’intérêt de faire fonctionner plusieurs réseaux sociaux comme un seul.

Dans le fédivers, tous les rôles que nous avons décrit plus haut sont gérés par des acteurs différents qui ont des noms différents : le réseau social s’appelle « fédivers », le protocole « ActivityPub », et les logiciels sont très nombreux (on vous en présente quelques uns plus bas). Cela peut donner une sensation de complexité pour les utilisateur·rices, mais c’est ce qui garantit l’ouverture du réseau, la possibilité d’en créer de nouvelles parties, et permet surtout la déconcentration des pouvoirs.

Dans le fédivers, on trouve par exemple des alternatives à Twitter : Mastodon est la plus connue, mais il existe aussi GNU social, Pleroma, Misskey et d’autres. Il y a Peertube, une alternative à Youtube, Plume, une alternative à Medium, Mobilizon qui permet d’organiser des événements (et remplace les événements Facebook), Pixelfed, qui permet de partager des images et se propose comme alternative à Instagram, Lemmy, une alternative aux sites-forums d’agrégation d’actualité comme Reddit, ou encore Funkwhale qui permet d’héberger et partager des fichiers audio et se propose en alternative à Deezer ou Spotify.

Notons la place importante de nos ami·es de Framasoft dans le développement de cet écosystème de logiciels libres, notamment à travers leur travail sur Mobilizon et Peertube ainsi que le rôle des CHATONS, collectif d’hébergeurs alternatifs qui hébergent et administrent de nombreuses instances de réseaux sociaux décentralisés.

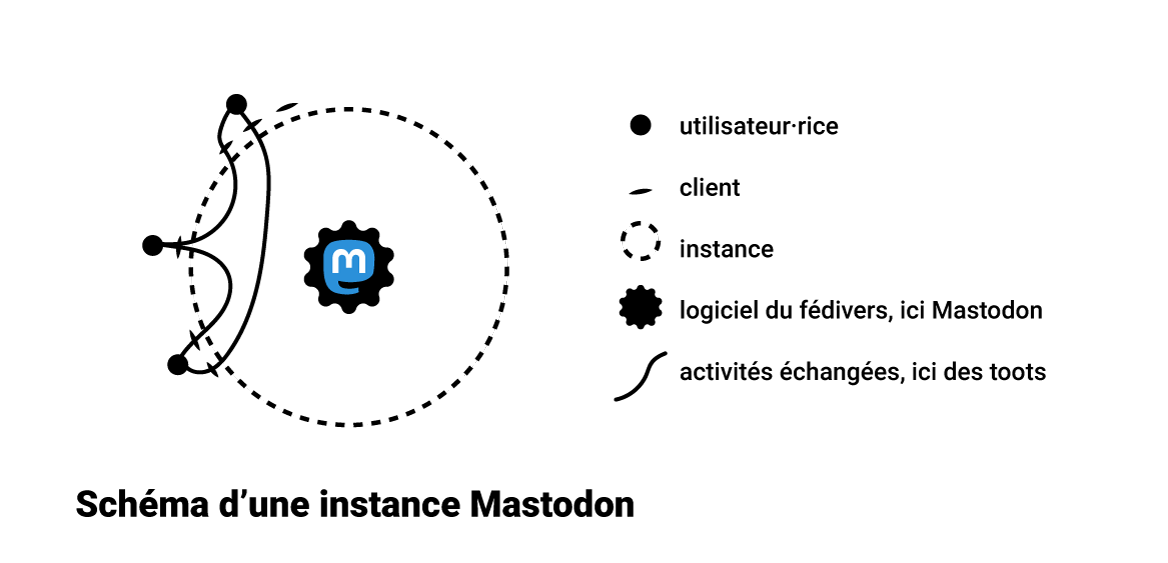

Le fédivers fonctionne sur le principe de fédération : pour faire partie du réseau, il faut créer ou rejoindre une instance. Une instance est une version installée sur un serveur d’un logiciel qui communique avec ActivityPub. N’importe qui peut donc créer une instance. La Quadrature du Net a par exemple une instance Mastodon, mamot.fr.

Voici un schéma d’une instance Mastodon.

Contrairement aux réseaux sociaux commerciaux, on peut y accéder via des clients différents :

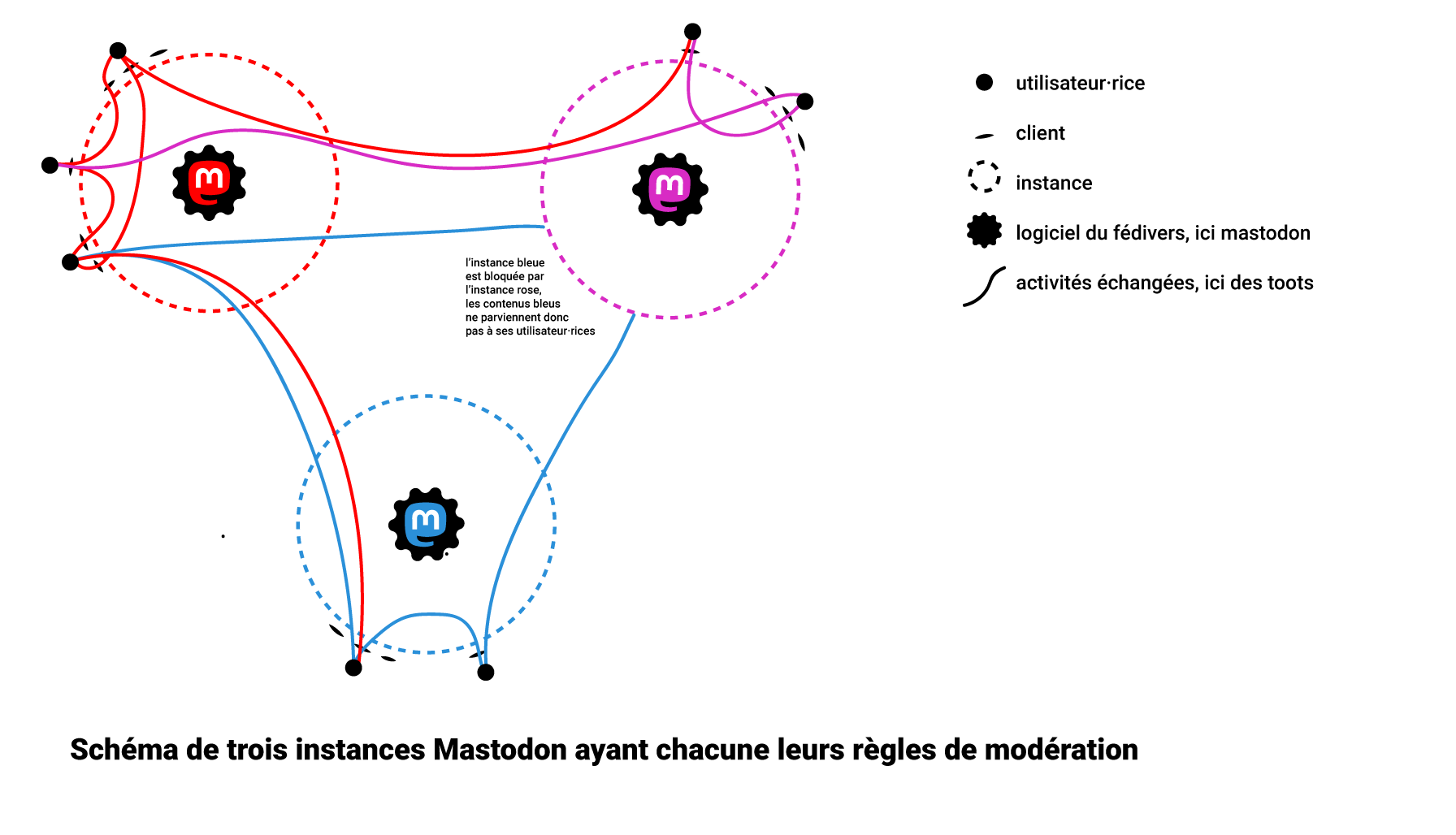

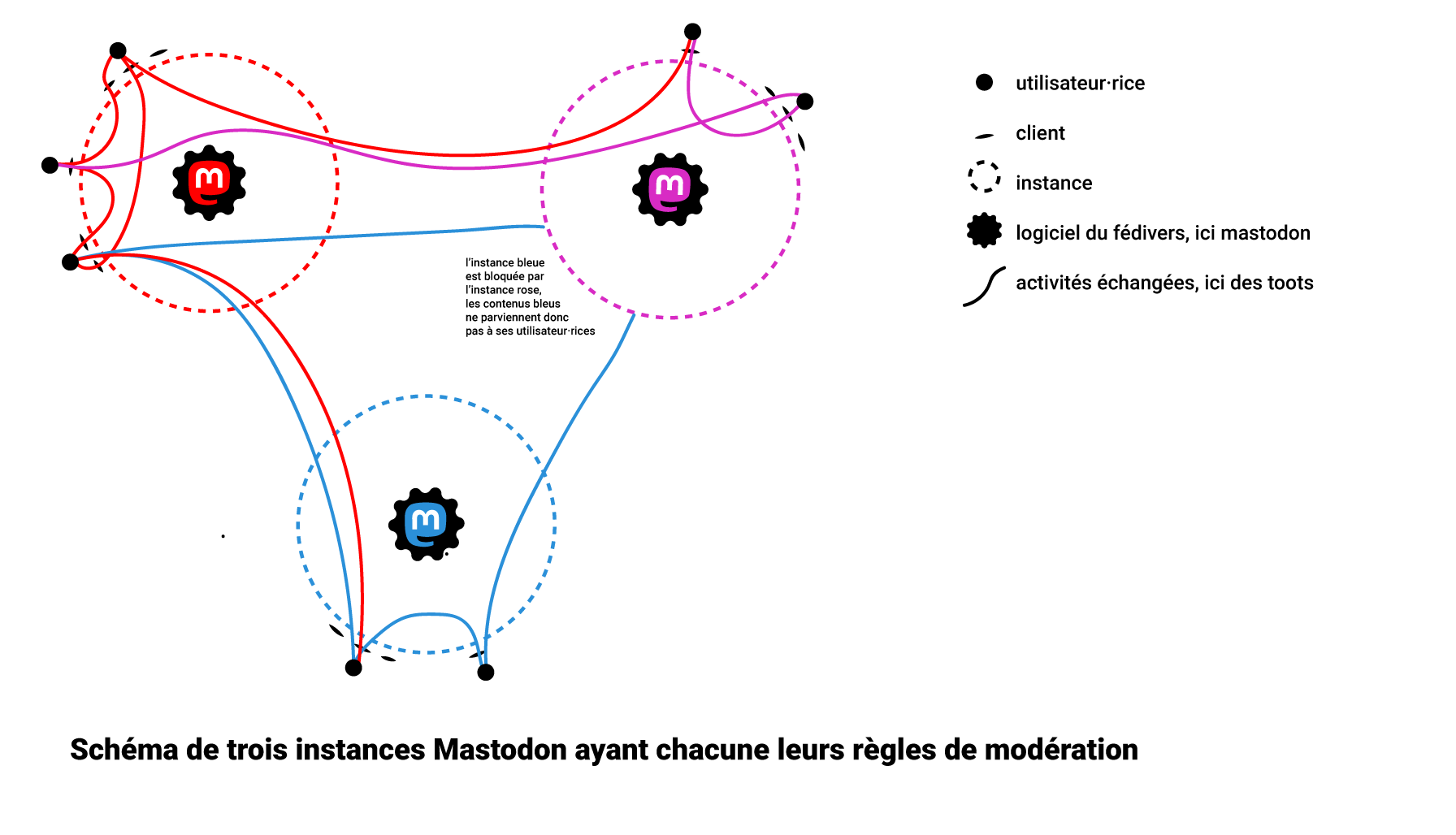

Contrairement aux réseaux sociaux commerciaux, plusieurs instances Mastodon peuvent se fédérer et permettre à leurs utilisateur·rices de communiquer entre elles tout en ayant des règles de modération différentes. Mais il y a également une nouveauté supplémentaire : différents logiciels, à partir du moment où ils sont basés sur ActivityPub, peuvent communiquer entre eux même si leurs usages sont différents. Ainsi, une personne avec un compte sur une instance Mastodon (dont l’usage est du micro-blogging) peut s’abonner à un compte PixelFed (partage d’images) ou bien commenter des vidéos hébergées sur une instance Peertube (partage de vidéos).

Nombreux·ses sont les utilisateur·rices qui souffrent de la démultiplication des comptes sur les messageries et les réseaux sociaux. L’interopérabilité pourrait devenir une solution permettant à chaque utilisateur·rices d’avoir des comptes uniquement sur les services qui l’intéressent tout en ayant la possibilité de communiquer avec quelqu’un ayant un compte sur n’importe quel autre service interopérable.

Régulation de l’expression par la décentralisation

La première étape pour transformer l’écosystème des réseaux sociaux passe donc par la possibilité pour les utilisateur·rices de se diriger vers les alternatives existantes, qui leur montreront ce que donnent des logiques de modération différentes de celles des réseaux sociaux commerciaux. Les logiciels de réseaux sociaux existants utilisant des protocoles interopérables proposent déjà des services qui permettent aux utilisateur·rices de s’extraire de la surveillance et de l’organisation des contenus au service de la publicité, de choisir parmi une multitude de régimes de modération différents, et même d’en créer de nouveaux.

On peut d’ores et déjà observer la différence, en termes de diffusion des contenus, qu’apporte le caractère décentralisé des politiques de modération, via une comparaison entre Mastodon et Twitter. Sur Mastodon, la modération est effectuée à l’échelle des instances (et donc de chaque serveur sur lequel est installée le logiciel Mastodon). Elle est faite par des personnes humaines, se référant aux règles de modération établies par l’instance en question. Les contenus problématiques ne bénéficient pas d’une viralité boostée comme sur Twitter ; au contraire, leur viralité est même plutôt freinée par les décisions de modération de chaque instance au fur et à mesure que les contenus atteignent différentes instances en étant partagés par des utilisateur·rices.

Ce système de modération est bien plus fin que la modération par algorithmes car les personnes humaines qui modèrent chaque instance ont une meilleure compréhension du contexte et se réfèrent à des règles collectives correspondant à l’espace d’expression dont elles sont les actrices. Par ailleurs, la décision de modérer ou non un contenu est beaucoup moins lourde de conséquences car elle n’entraîne pas pour tout le monde une interdiction d’accès au contenu : seule l’instance hébergeant le compte qui a posté le contenu peut le supprimer complètement. Une instance peut donc modérer un contenu chez elle, sans que cela n’impacte la manière dont le contenu sera vu sur les autres instances. Il n’y a donc pas de censure hégémonique. De cette manière, la logique décentralisée prend bien plus en compte la complexité du monde des espaces d’expression : elle accepte que la validité d’un propos ne soit pas binaire et dépende de l’espace où il est exprimé et des règles que celui-ci s’est données.

De nouveaux usages possibles grâce à l’interopérabilité

Ces initiatives sont pour la plupart en cours de développement et beaucoup de critiques peuvent leur être faites. Pour reprendre l’exemple précédent de la comparaison entre Mastodon et Twitter, de nombreux problèmes subsistent : Mastodon étant très largement inspiré de Twitter, il en copie le fonctionnement en favorisant par défaut les contenus publics, en étant construit comme une grande arène uniquement constituée de comptes d’individus, en valorisant le sentiment de récompense rattaché aux outils de mesure de la « performance d’un contenu » (les partages et les favoris), etc. Le fonctionnement par instance maintient corrélées les décisions de modération et la question de l’hébergement : les personnes ayant la capacité technique d’héberger une instance ont plus de pouvoir que les personnes qui n’ont pas cette capacité technique puisqu’elles en seront la plupart du temps administratrices.

Les critiques et pistes d’amélioration sont nombreuses et déjà très investies par l’écosystème de développeur·euses et d’utilisateur·rices des réseaux sociaux décentralisés. Parmi les réflexions en cours, celles s’intéressant aux modes de décisions collectives sont particulièrement intéressantes. Il y a un fort enjeu pour les groupes à avoir des outils en ligne qui leur permettent de s’organiser aussi librement qu’ils le souhaitent.

Ainsi, le protocole Scuttlebut propose un fonctionnement entièrement basé sur l’auto-hébergement et le pair-à-pair : les contenus sont hébergés directement par les utilisateur·rices et circulent de manière chiffrée au sein du réseau sur la logique du bouche-à-oreilles. Comme dans des discussions entre ami·es : on ne peut savoir ce qu’a dit quelqu’un que si quelqu’un d’autre nous le répète, le tout restant privé.

De même, Bonfire est un logiciel de réseau social basé sur ActivityPub qui permet de faire du microblogging. Il permet de reproduire les usages de type « Twitter », comme les alternatives que nous avons précédemment mentionnées, mais tente aussi de proposer de nouvelles fonctionnalités comme la possibilité de faire exister des logiques de groupes ou encore d’avoir une interface adaptable à différents usages.

Enfin, on soulignera les travaux de l’association Technostructures, qui formule plusieurs critiques à l’égard du protocole ActivityPub : le lien indissociable entre hébergement de l’instance et pouvoir de modération et le caractère public par défaut des contenus. C’est sur ce constat qu’elle développe Posca, un réseau social qui n’est pas basé sur le protocole ActivityPub mais sur le protocole Matrix (tout en proposant tout de même la fédération avec le fédivers via un pont). L’usage du protocole Matrix apporte aussi l’avantage que les échanges sont chiffrés.

Un autre enjeu est celui de l’avenir des réseaux sociaux. Les vieux réseaux sociaux commerciaux semblent depuis longtemps s’être figés. Parce qu’ils n’ont plus besoin d’attirer les utilisateur·rices avec de nouveaux usages intéressants depuis qu’ils les ont rendus captif·ves, on n’y voit quasiment plus rien de nouveau. Les quelques nouveautés ne servent que l’objectif économique des entreprises, comme la mise en avant par Meta de la réalité virtuelle à travers son idée de Metaverse qui répondait à une logique de création d’un nouveau marché (sur lequel Meta aurait eu un monopole grâce à son fonctionnement en silo) et s’est écroulée car ne répondant à aucun usage des utilisateur·rices. Il y a pourtant de nombreuses pistes à explorer pour proposer des usages réellement utiles aux groupes et aux personnes qui cherchent le bon moyen de communiquer. Promouvoir l’interopérabilité, c’est aussi rouvrir la question des usages médiatiques du Web et de leur devenir.

Forcer l’interopérabilité : stratégies politiques et juridiques

Il ne faut bien évidemment pas compter sur les réseaux sociaux commerciaux pour être interopérables de leur plein gré. La Quadrature du Net demande donc, depuis 2019, que soit instaurée dans le droit une obligation d’interopérabilité des grands réseaux sociaux.

Le refus du législateur jusqu’à présent d’instaurer une obligation d’interopérabilité

En France, la députée Laetitia Avia (LREM) a fait voté en 2020 une proposition de loi qui, sous couvert de lutte contre la haine en ligne, instaurait un gigantesque dispositif de censure obligatoire et arbitraire. Lors des débats parlementaires, La Quadrature a rappelé qu’il existe une autre manière de réguler les plateformes et de lutter contre la haine en ligne, sans passer par la censure, grâce à l’obligation d’interopérabilité afin de permettre aux internautes de quitter une plateforme toxique. Ainsi, en 2019, plus soixante-dix organisations, aux côtés de La Quadrature, demandaient au législateur d’obliger les grands réseaux sociaux commerciaux à être interopérables. Le choix du législateur a été d’ignorer cet appel, de rester dans une vision de régulation par la censure, et cette loi est aujourd’hui tombée dans les oubliettes de la République depuis que le Conseil constitutionnel l’a quasiment intégralement déclarée contraire à la Constitution.

Lorsque l’Union européenne a voulu réformer son cadre juridique sur le numérique avec le Digital Services Act (règlement sur les services numériques, ou DSA) et le Digital Markets Act (règlement sur les marchés numériques, ou DMA), de nombreuses associations de défense des libertés, dont La Quadrature, EDRi, ARTICLE 19, ou encore l’Electronic Frontier Foundation ont demandé à ce qu’une obligation d’interopérabilité des réseaux sociaux soit inscrite dans ces textes législatifs : l’Union européenne avait enfin l’occasion d’innover dans sa manière de réguler les géants du net. Le Parlement européen a été réceptif à cet appel : la version du DMA votée par le Parlement européen comportait une obligation d’interopérabilité des grands réseaux sociaux. Mais c’était sans compter sur les efforts de la France et de Cédric O, alors secrétaire d’État au numérique. Lors des négociations sur le DMA, la France, alors présidente du Conseil (l’autre organe législatif de l’UE à côté du Parlement européen), a obtenu, à la toute fin des négociations, le retrait de cette obligation d’interopérabilité.

Enfin, récemment, le gouvernement français a présenté en mai 2023 un projet de loi visant à sécuriser et réguler l’espace numérique (aussi appelé « SREN ») dont l’objectif est, entre autres, de réguler les plateformes en ligne. Là encore, de la même manière que la loi Avia, le gouvernement a préféré la solution de la censure à celle de l’interopérabilité des réseaux sociaux, grande absente. Et ici encore, alors que des député·es de gauche et du centre avaient proposé d’instaurer une forme d’obligation d’interopérabilité, le gouvernement s’y opposa. La raison de son refus ? Nous ne la connaîtrons pas : le ministre du numérique Jean-Noël Barraut n’a pas pris la parole pour s’expliquer, se contentant d’un lapidaire « Défavorable », et la majorité présidentielle suivit sagement l’avis négatif du ministre pour rejeter les amendements proposés.

Un rapport de force entre grandes plateformes et États d’une part, et société civile d’autre part

Alors que l’obligation d’interopérabilité des réseaux sociaux aurait pu devenir une réalité si la France et Cédric O n’avaient pas autant bataillé contre, les déclarations de ce dernier éclairent assez bien le rapport de force qui se joue aujourd’hui.

Dès 2019 en effet, Cédric O se montrait très réticent à l’idée d’obliger les grands réseaux sociaux à être interopérables. Devant la commissions des lois de l’Assemblée nationale, il regrettait le caractère « excessivement agressif pour le modèle économique des grandes plateformes » d’une obligation d’interopérabilité. Autrement dit, le secrétaire d’État a préféré sacrifier les libertés publiques et la possibilité d’explorer de nouvelles manières de s’exprimer en ligne sur l’autel des intérêts économiques des grandes plateformes.

Il y a donc un véritable rapport de force aujourd’hui autour de la question de l’obligation d’interopérabilité des réseaux sociaux, où grandes plateformes et États travaillent de concert. Meta, notamment, n’a pas hésité à critiquer l’interopérabilité pour ses risques – exagérés, nous revenons dessus plus bas – en termes de vie privée. Or, en juillet 2020, Facebook et Snapchat réussissaient à s’afficher aux côtés du Conseil national du numérique (CNNum) à l’occasion d’une table-ronde sur l’interopérabilité des réseaux sociaux et de la publication d’un rapport de l’institution très critique sur l’interopérabilité.

L’urgence à obliger les réseaux sociaux commerciaux à être interopérables

Il est particulièrement important d’agir et de faire en sorte que cette obligation d’interopérabilité des réseaux sociaux arrive vite, parce que de leur côté, les grands réseaux sociaux n’attendent pas. Reconnaissons un point à Cédric O lorsqu’il s’opposait pendant les débats sur la loi Avia à une telle obligation : elle remettra drastiquement en cause le modèle économique actuel des grands réseaux sociaux qui n’est possible, nous l’expliquions plus haut, que grâce à leur position hégémonique. Ces derniers n’investiront le champ de l’interopérabilité que s’ils y ont quelque chose à gagner.

Or, c’est précisément ce que voudrait faire Meta : lancer un réseau social interopérable sans attendre d’y être contraint par le législateur. L’entreprise a en effet annoncé à l’été 2023 que son nouveau réseau de microblogging, Threads, serait interopérable avec le reste du fédivers grâce au support du protocole ActivityPub. Bonne nouvelle ? Non, comme nous l’expliquions à l’époque. Meta profite de l’absence d’obligation d’être interopérable, donc de l’absence de régulation de ce domaine, pour devenir le plus gros acteur et ainsi, pouvoir peser sur les choix techniques du fédivers et du protocole ActivityPub.

En effet, aujourd’hui, parce qu’aucun réseau social n’a l’obligation d’être interopérable, le domaine de l’interopérabilité des réseaux sociaux n’est pas régulé. Cela fonctionne à peu près correctement lorsque l’écosystème des réseaux sociaux interopérables est composé de petits acteurs, qui ne cherchent pas le profit, donc qui ne voient pas le fédivers comme un marché à conquérir et qui ne cherchent pas à le canibaliser. Mais cet équilibre serait radicalement modifié avec l’arrivée d’une entreprise comme Meta : non seulement en raison de l’objectif commercial de Meta, mais également en raison du nombre d’utilisateur·rices qu’elles représenterait et du pouvoir d’influence que cela lui conférerait (les plus grosses instances Mastodon ont quelques centaines de milliers d’utilisateur·rices quand Facebook en a plusieurs milliards).

C’est pour cette raison qu’il est nécessaire que l’obligation d’interopérabilité s’accompagne d’une régulation de ce secteur. Aujourd’hui, même si la question de la nature de la régulation est ouverte, La Quadrature du Net estime, à défaut de meilleure solution, que celle-ci devrait prendre la forme d’un régulateur indépendant étatique, comme c’est le cas avec la régulation des télécoms et l’obligation de neutralité du net. En France, ce serait l’ARCEP, déjà chargée de réguler les télécoms. Ce régulateur aurait non seulement le pouvoir d’imposer aux géants les protocoles à implémenter (afin qu’un Meta ne puisse pas inventer son propre protocole fermé et ne l’ouvrir que partiellement pour garder le contrôle sur son évolution), mais pourrait également, avec des sanctions dissuasives, punir les réseaux sociaux commerciaux qui ne se plieraient pas à cette obligation (par exemple si un réseau social voulait se refermer après avoir capté une partie de la communauté, comme ce qu’il s’est passé avec Google et GTalk).

La proposition législative de La Quadrature

La Quadrature du Net a proposé à des député·es, à l’occasion du projet de loi SREN, d’instaurer une obligation d’interopérabilité par voie d’amendement. Deux amendements leur ont été proposés, qui peuvent être redéposés clé-en-main à l’occasion d’un futur véhicule législatif, voire être transformés en proposition de loi.

Le premier amendement vise à instaurer une véritable obligation d’interopérabilité. Il repose sur les définitions et seuils européen·nes et s’inspire de la proposition du Parlement européen d’instaurer une telle obligation dans le DMA. Lorsqu’un réseau social est un « contrôleur d’accès » (c’est-à-dire une grande plateforme) au sens de l’article 3 du DMA, il devra être interopérable. Cette obligation est contrôlée par l’ARCEP, qui voit ses pouvoirs de régulation et de sanction étendus à la question de l’interopérabilité.

Le deuxième amendement est un amendement de repli. Il n’instaure pas d’obligation d’interopérabilité, mais régule les plateformes qui, comme Meta, voudraient cannibaliser le fédivers. Cet amendement de repli repose sur les mêmes définitions du DMA, mais ne prévoit d’obligation de respecter les règles de l’ARCEP que si le réseau social commercial appartient à un « contrôleur d’accès » et est interopérable.

Prévoir les impacts de l’interopérabilité

Nous avons évoqué de nombreuses formes que peuvent prendre les réseaux sociaux grâce à l’interopérabilité, à travers les initiatives existantes : en reprenant certaines logiques des réseaux sociaux dominants dans une version décentralisée ou en proposant de nouvelles logiques de diffusion de l’information. On ne peut pas prévoir de manière certaine les dynamiques que provoqueraient une obligation d’interopérabilité. Toutefois, il est important d’envisager que cette obligation (ou la menace de la création d’une telle obligation) va provoquer des tentatives de « prise de marché » de la part du monde commercial.

Protocole ouvert = accès massif aux données ?

Pouvoir acceder aux informations et publications de nos proches sur les réseaux sociaux commerciaux, c’est aussi permettre aux personnes sur les réseaux sociaux commerciaux d’accèder aux informations et aux publications des personnes sur les réseaux sociaux non commerciaux qui ont une politique de gestions des données personnelles protectrice. Cela soulève donc la question suivante : l’interopérabilité risque-t-elle de donner une opportunité technique au réseaux sociaux commerciaux de récupérer également les informations issues des autres réseaux sociaux ? Bien sûr, cela serait parfaitement illégal, mais on ne peut pas faire confiance aux réseaux sociaux commerciaux pour respecter la loi, ils ne le font déjà pas.

Il est aujourd’hui déjà possible de collecter les informations publiquement accessibles sur un réseau social, en collectant les pages web qui contiennent les informations recherchées. Il est techniquement possible de faire une copie de toutes les pages publiques d’un réseau social pour analyser leur structure HTML et extraire le contenu (on appelle cela du scraping). Mais cette manière de faire est compliquée : il faut passer d’un contenu non-structuré (une page HTML) à un contenu structuré (l’information intéressante dans cette page HTML), ce qui n’est possible que par une analyse fine de la structure de la page HTML. Cette analyse est complexe mais les outils existent déjà ; c’est ce que fait par exemple l’administration fiscale française.

Or, l’intéropérabilité facilite la collecte par un acteur malveillant de données puisque le protocole servant à différentes instances pour communiquer entre elles (ActivityPub pour le fédivers) vise, précisément, à structurer les données. Mais cette facilitation technique de la collecte de données n’est pas le propre de l’interopérabilité : certains réseaux sociaux commerciaux proposent, parfois moyennant finances ou à des conditions strictes d’utilisation, des API (« application programming interface », ou « interface de programmation d’application ») qui permettent de structurer les données. Pour reprendre le cas de l’administration fiscale, celle-ci utilise ces API lorsqu’elle en a la possibilité et ne procède à du scraping que dans le cas où ces API ne sont pas disponibles.

Il est donc vrai que l’interopérabilité facilite le travail d’un acteur malveillant qui voudrait collecter des données. Mais il ne crée pas de nouveau risque à proprement parler, d’autant que ces outils de scraping sont largement à la portée des géants du Web.

Toutefois, ce débat – éminemment légitime – a pris de la place sur le fédivers lorsque l’entreprise Meta a annoncé la sortie de Threads, à terme basé sur le protocole ActivityPub donc pouvant communiquer avec d’autres instances du fédivers. Certain·es utilisateur·rices du fédivers ont notamment eu peur de voir leur données récupérées par Meta et de nombreuses instances ont même signé le « Fedipact », s’engageant à bloquer Threads.

En effet, une grande partie des utilisateur·rices du fédivers est particulièrement soucieuse aux questions de collecte de leur données personnelles. Nous ne pensons pas pour autant que cette crainte doive bloquer la possibilité de permettre aux personnes toujours captives des réseaux sociaux commerciaux de s’en echapper.

Décentraliser les espaces de discussions, c’est enlever du pouvoir aux États

Comme on l’a expliqué plus haut, l’interopérabilité a beaucoup d’avantages : pourquoi, alors, les États persistent-ils à vouloir maintenir des espaces de discussions centralisés au sein de quelques acteurs commerciaux ? Parce que cela répond à leur logique de recherche de pouvoir.

La régulation de l’expression en ligne est parsemé d’exemples où les États ont voulu accroître leur pouvoir. Il y a tout d’abord la question de la censure des expressions : avec le règlement européen « terroriste », il est possible pour une police de n’importe quel État de l’UE d’obliger le retrait d’un contenu, sans passer par un juge, qu’elle estimerait être à caractère terroriste. Avant les contenus terroristes, au début des années 2010, ce sont les contenus d’abus sur enfant qui ont, les premiers, été le prétexte pour ouvrir la boîte de Pandore de la censure administrative.

Or, il est beaucoup plus facile pour un État de discuter avec quelques acteurs commerciaux qui suivent des logiques de marchés et qui seront sensibles aux menaces économiques, qu’avec des collectifs informels, mouvants et difficilement palpables comme le fédivers en comporte. Les États ont donc intérêt à maintenir l’hégémonie des géants, puisqu’ils auront face à eux un petit nombre d’acteurs clairement identifiés.

Cette centralisation des réseaux sociaux permet de plus facilement faire pression sur eux pour censurer, y compris en dehors de tout cadre légal. Ainsi, à l’été 2023, lorsque des révoltes ont éclaté en France suite au meurtre par un policier d’un adolescent, la classe politique a ignoré les causes sociales de cette colère, et a préféré ressortir le vieux bouc émissaire des réseaux sociaux. Certains parlementaires et ministres, ainsi qu’Emannuel Macron, ont suggéré d’accentuer les obligations de censure s’imposant aux plateformes. Or, sans attendre une évolution législative, les réseaux sociaux commerciaux se sont s’exécuté. Ainsi, après une « convocation » par le ministère de l’intérieur, la responsable des affaires publiques de Snapchat, Sarah Bouchahoua (ancienne collaboratrice de Laetitia Avia), n’hésitait à révéler devant l’Assemblée nationale que, sur demande du gouvernement, le réseau social avait procédé au retrait de certains contenus. Une censure extralégale, qui repose sur une interprétation arbitraire et a maxima des conditions générales d’utilisation de la plateforme.

On voit bien le problème pour les États d’une généralisation des réseaux sociaux interopérables. Le ministre de l’intérieur ne pourra pas « convoquer » le fédivers. Ses décisions de censures, si elles sont illégitimes, seront d’un effet beaucoup plus réduit. Si une instance se voyait bloquée arbitrairement, ses utilisateur·rices pourraient migrer ailleurs.

Conclusion

Depuis 2019, date où nous avons commencé à expliquer aux parlementaires la nécessité de prévoir dans la loi une obligation d’interopérabilité, nos constats sur les dangers des pratiques hégémoniques des réseaux sociaux commerciaux n’ont pas bougé. Ce qui a évolué en revanche, c’est la volonté croissante des internautes de s’en libérer. Nous avons ainsi vu s’enchaîner les vagues de migration d’utilisateur·rices vers les alternatives. L’Internet libre aussi a bougé et foisonne de nouvelles initiatives porteuses d’idées à même de réellement réinventer le monde des réseaux sociaux. Nous avons également vu apparaître des stratégies d’interopérabilité adversarielle, c’est-à-dire des stratégies pour libérer de force les contenus présents sur les réseaux sociaux commerciaux et les rendre accessibles depuis d’autres services.

Malheureusement, nous avons aussi assisté à un enchaînement de lois de censure, cherchant à « réparer » les problèmes des réseaux sociaux tout en les confortant dans leur centralisation et leur hégémonie. L’interopérabilité devient une urgence.

Ce n’est pas la première fois que nos droits à communiquer et à partager des informations sont remis en question par la position hégémonique d’intermédiaires techniques à des fins commerciales. Dans les années 2010, les fournisseurs d’accès Internet ont cherché à tirer plus de profit de leur position en tentant de filtrer ou de ralentir l’accès à certains sites. Pour assurer un accès à Internet sans restriction de leur part, nous avons érigé la neutralité du net en principe fondamental d’Internet. Aujourd’hui face à la surveillance, la censure, les régimes de modération uniques et unilatéraux nous devons tous·tes ensemble pousser le principe d’interopérabilité et le rendre obligatoire pour les réseaux sociaux hégémoniques.

Nous plaçons la promotion l’interopérabilité des réseaux sociaux dans nos principaux combats pour l’année 2024. Ce principe est encore bien trop méconnu du grand public et une adhésion massives des populations faciliterait son insertion dans un texte de loi. Parlez donc de l’interopérabilité autour de vous !

Et pour soutenir La Quadrature du Net, n’hésitez pas à nous faire un don.

Faire un don

︎

︎ ︎

︎ ︎

︎ ︎

︎

︎

︎